基于 PyCharm 使用 Tabby 和 CodeGPT 插件搭建免费的 GitHub Copilot

使用的模型

- 代码生成

Tabby使用的是Deepseek Coder 6.7B模型。 - AI 聊天

CodeGPT使用的是ChatGLM3-6B模型。这个后面考虑使用Deepseek Coder 6.7B来替换。

部署服务器端

Tabby 服务

docker run -d --runtime nvidia --name tabby -p 8080:8080 \

-e TABBY_DOWNLOAD_HOST=modelscope.cn \

-e NVIDIA_VISIBLE_DEVICES=3 \

-e RUST_BACKTRACE=1 \

-v `pwd`/.tabby:/data tabbyml/tabby \

serve --model TabbyML/DeepseekCoder-6.7B --device cuda

OpaneAI 服务

- 启动服务

Controllerpython -m fastchat.serve.controller - 启动服务

Model Workerpython -m fastchat.serve.model_worker \ --model-path THUDM/chatglm3-6b --port 21002 \ --worker-address http://localhost:21002 \ --model-names chatglm3-6b,gpt-3.5-turbo - 启动服务

OpenAI API Serverpython -m fastchat.serve.openai_api_server --port 8000

安装 PyCharm

安装插件

插件

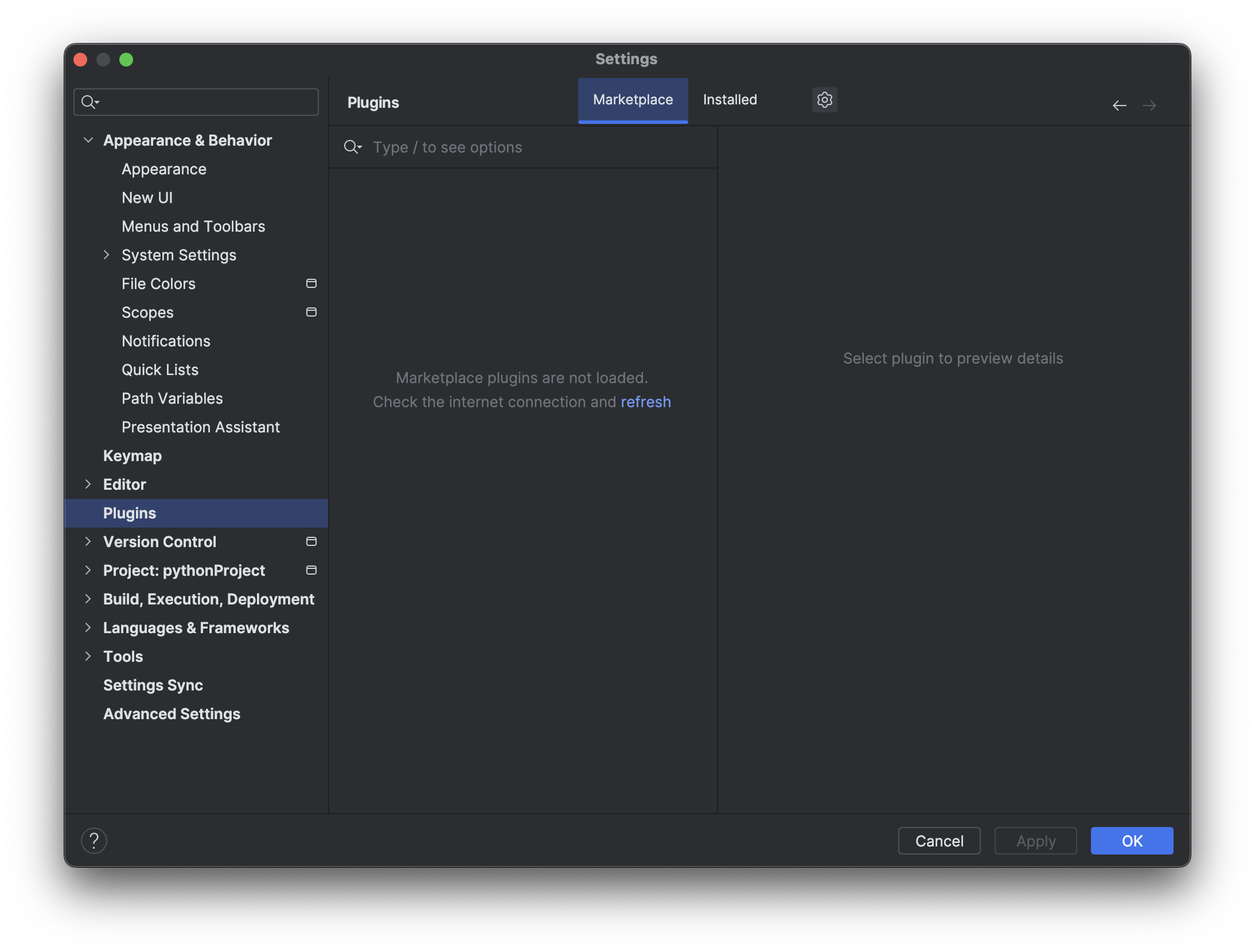

安装方法一

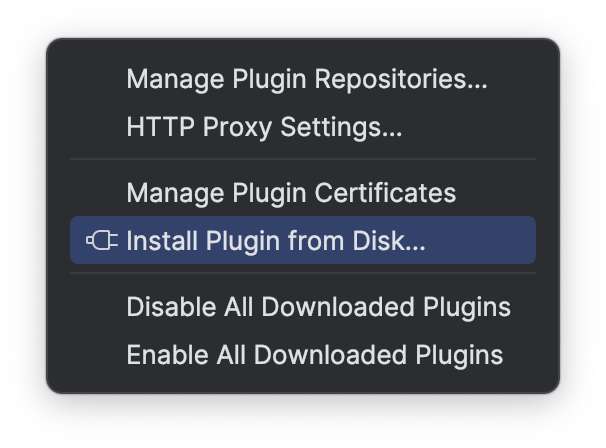

使用 PyCharm 安装插件,发现找不到插件,需要手动下载插件安装包,然后通过 PyCharm 安装本地插件。

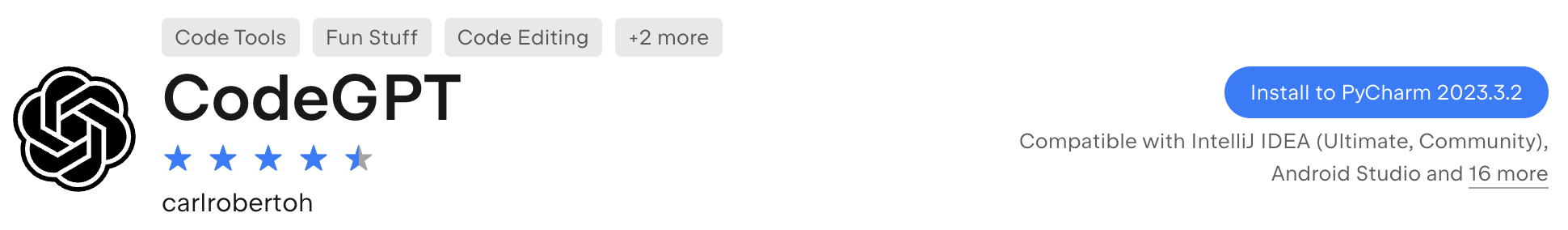

安装方法二

如果您打开 PyCharm IDE 后,然后到插件市场找到插件,可以看到 Install to PyCharm 按钮,点击后会自动下载并安装插件。

配置插件

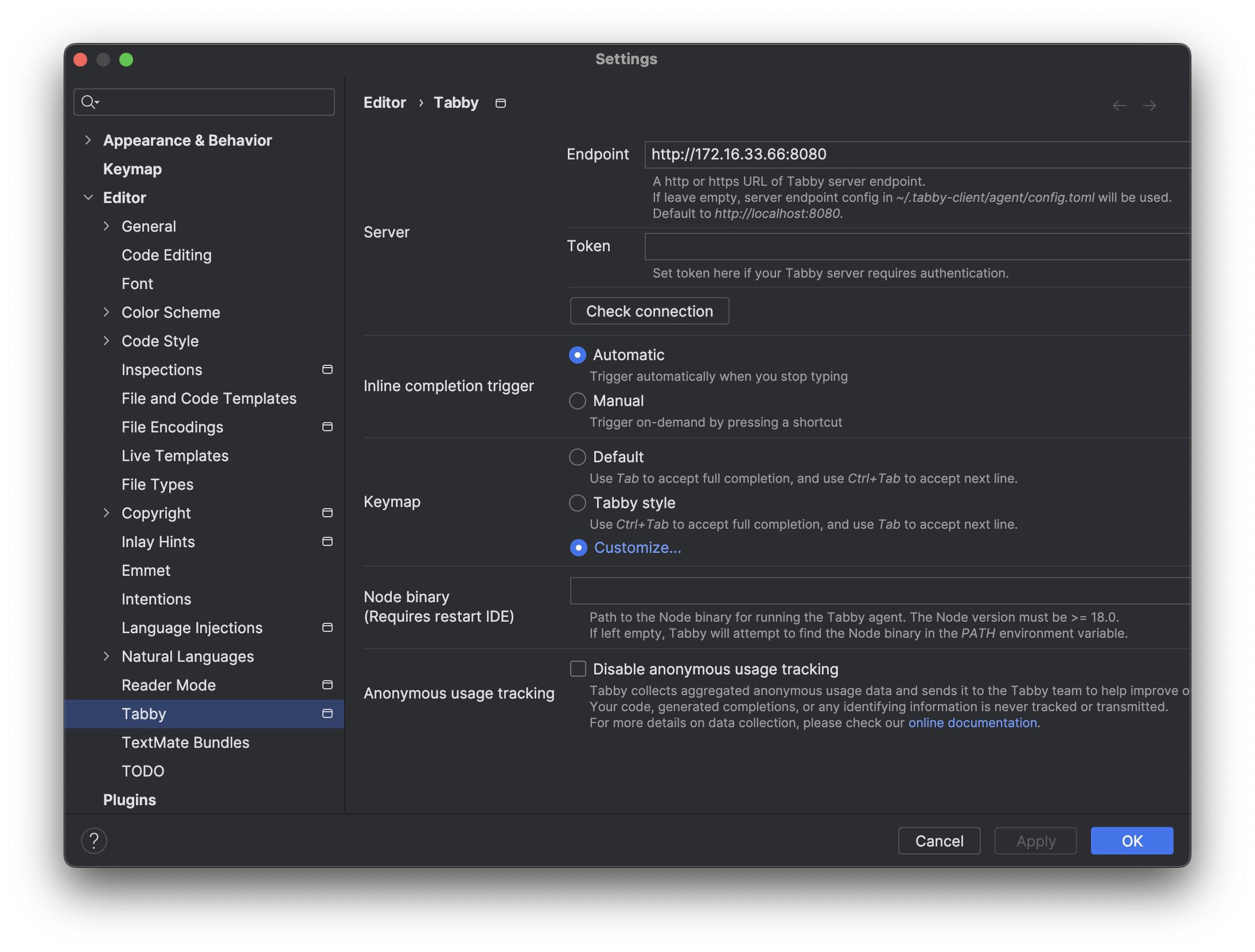

Tabby

参数

- EndPoint:

http://172.16.33.66:8080

CodeGPT

参数

- Service:

OpenAI Service - API key:

NULL - Model:

GPT-3.5(4k) - Base host:

http://172.16.33.66:8000

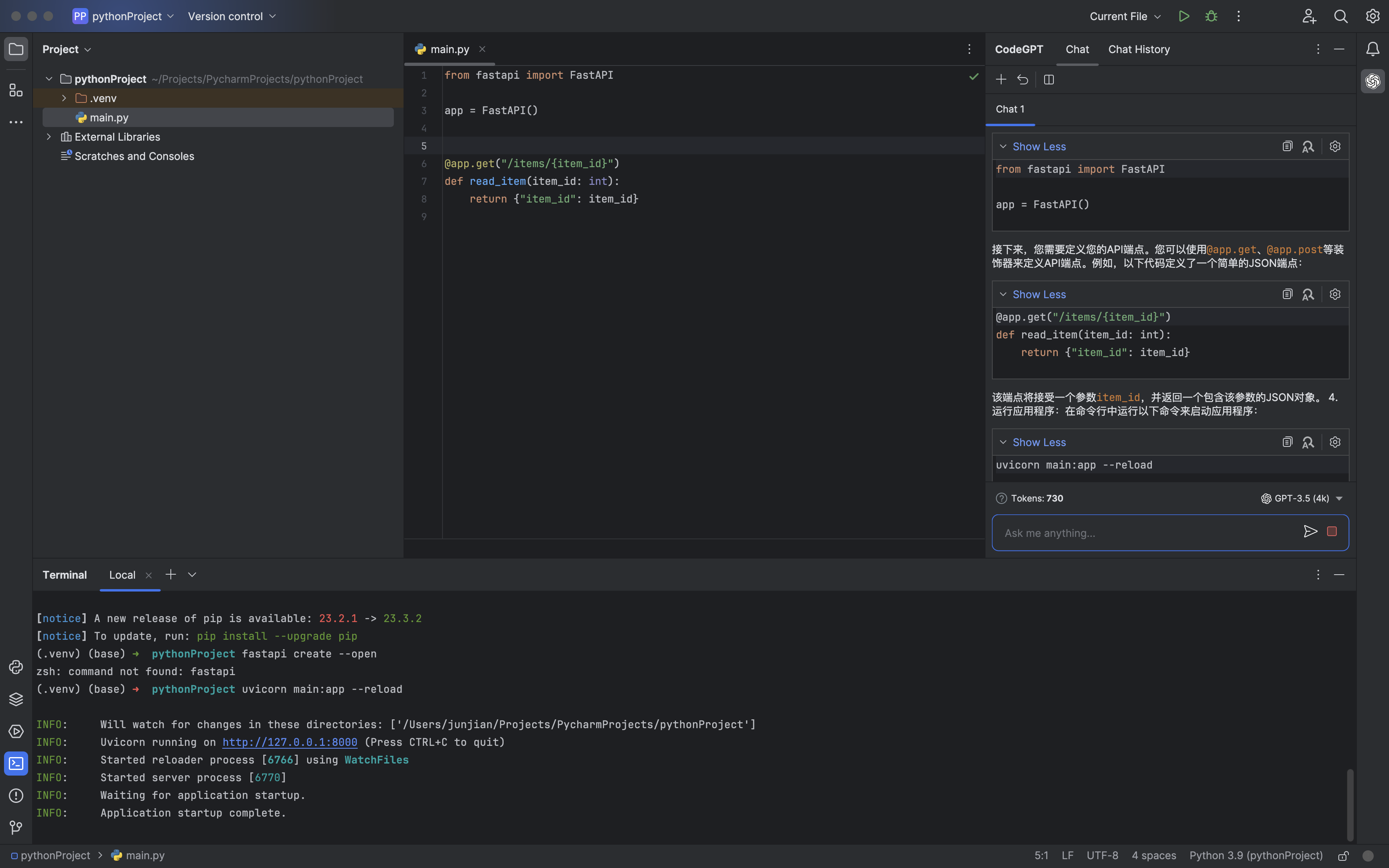

使用插件

AI 聊天

代码生成